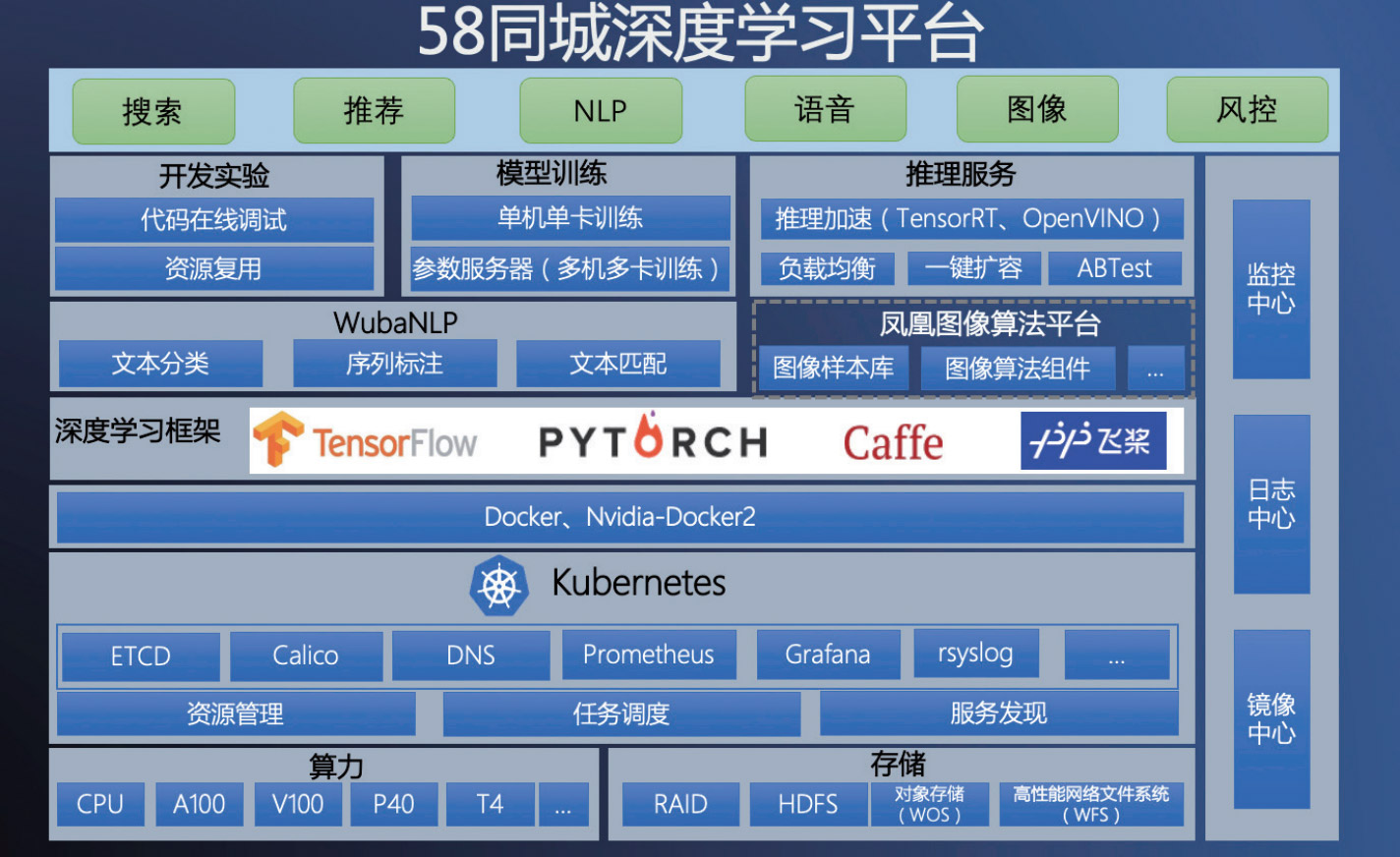

58 同城深度學習平台,是集開(kāi)發實驗、模型訓練和在線預測爲一(yī)體(tǐ)的一(yī)站式算法研發平台,旨在爲各業務部門賦能 AI 算法研發能力,支撐了 58 同城搜索、推薦、圖像、NLP、語音、風控等 AI 應用。作爲中(zhōng)國最大(dà)的生(shēng)活信息服務商(shāng),58 同城不斷在提高深度學習平台性能,提高平台資(zī)源使用率,從而更好的提升用戶體(tǐ)驗。

58 同城探索了在基于第二代英特爾® 至強® 可擴展處理器的 CPU 服務器上進行推理優 化,并進行了測試。測試數據顯示,CPU 服務器在部分(fēn)場景下(xià)能夠實現比 GPU 服務器 更高的推理性能,同時在 TCO、部署靈活性等方面更具優勢。在計算機視覺領域的強 勁算力需求下(xià),也能夠可靠的支撐快速增長的業務需求。

背景:58 同城使用在線推理爲用戶提供精準服務

58 同城的業務廣泛涵蓋招聘、房産、車(chē)輛、兼職、黃頁等海量的生(shēng)活分(fēn)類信息,随着 各個業務線業務的蓬勃發展,58 同城上的分(fēn)類信息呈現出爆炸性增長的趨勢。對不同 場景下(xià)的需求做好分(fēn)類信息處理,已成爲一(yī)個重要問題。以房産場景爲例,用戶每天會 上傳大(dà)量的房源相關圖片,系統如何根據用戶上傳的海量圖片信息,精準快速的進行識 别與分(fēn)類,是提升用戶體(tǐ)驗、增加業務收益的關鍵。

爲了提高深度學習平台在線推理的性能,同時盡可能降低系統的總體(tǐ)擁有成本(TCO), 目前,基于深度學習模型的預測服務優化已經成爲了一(yī)個重 要方向。在圖像領域的算法模型中(zhōng),如 ResNet、CRNN、 YOLOv5 等,都對硬件算力有較大(dà)的需求。如果采用 GPU 服 務器來進行深度學習模型推理,将涉及到專用 GPU 硬件的采 購,以及配套的搭建、運維等成本,不僅靈活度較低、應用範 圍受限,而且也可能會帶來較高的 TCO 壓力。同時,在 GPU 服務器上進行深度學習推理往往需要複雜(zá)的部署、調優過程, 門檻相對較高,難以滿足新增應用快速上線的需求。 與 GPU 服務器相比,CPU 服務器具備更強的靈活性、敏捷性, 能夠支持大(dà)數據、雲計算、虛拟化等多種業務的彈性擴展, 方便部署和管理,滿足企業不同業務場景的動态資(zī)源需求。 此外(wài),通過面向 AI 工(gōng)作負載的技術特性升級以及性能優化, CPU 已經能夠廣泛滿足用戶不同 AI 應用對于算力的要求。 解決方案:英特爾® 至強® 可擴展處理器 + OpenVINO™ 工(gōng)具套件提升推理性能 爲了構建更高效、更具經濟性的在線推理系統,58 同城推出 了基于英特爾® 至強® 可擴展處理器的 CPU 推理服務器方案。 該方案除了搭載高性能、面向人工(gōng)智能應用進行優化的第二代 英特爾® 至強® 可擴展處理器,還通過 OpenVINO™ 工(gōng)具套件 進行了性能優化,從而進一(yī)步發揮性能潛力。 第二代英特爾® 至強® 可擴展處理器内置人工(gōng)智能加速功能, 并已針對工(gōng)作負載進行優化,能夠爲各種高性能計算工(gōng)作負 載、AI 應用以及高密度基礎設施帶來一(yī)流的性能和内存帶寬。

同時,采用矢量神經網絡指令(VNNI)的英特爾® 深度學習加 速(英特爾® DL Boost)顯著提高了人工(gōng)智能推理的表現,這使其成爲進行深度學習應用的卓越基礎設施。

OpenVINO™ 工(gōng)具套件支持加快部署廣泛的深度學習推理應用 和解決方案,可支持開(kāi)發人員(yuán)使用行業标準人工(gōng)智能框架、标 準或自定義層,将深度學習推理輕松集成到應用中(zhōng),在英特爾® 硬件(包括加速器)中(zhōng)擴展工(gōng)作負載并改善性能。借助面向 預推理模型的内置模型優化器(Model Optimizer,MO), 和面向專用硬件加速的推理引擎(Inference Engine,IE)運 行時,OpenVINO™ 工(gōng)具套件可在英特爾不同平台上部署并加 速神經網絡模型,能夠在保持精度的同時顯著提高圖像推理速度。

署環境之間的轉換,執行靜态模型分(fēn)析并調整深度學習模型, 緻力于在終端目标設備上實現最優執行能力。它支持從流行的 框架(包括 TensorFlow/ONNX/模型)到中(zhōng)間數據格式(IR, intermediate representation)的離(lí)線模型轉換。推理引擎則 提供統一(yī)的跨平台 C、C++ 和 Python API,用于推理加速和 優化。

OpenVINO Model Server 是高性能 K8S 容器化的 AI 服務部 署工(gōng)具,可實現便捷高效的 AI 推理服務部署與運維。該工(gōng)具 依賴标準的 gPRC 和 RESTful 網絡接口,針對不同的 AI 業務 功能,無需重複編寫代碼,即可實現新模型算法服務上線。該 工(gōng)具同時集成了高度優化的推理進程,支持英特爾不同硬件平 台資(zī)源的調度

驗證:50% 以上的推理性能提升

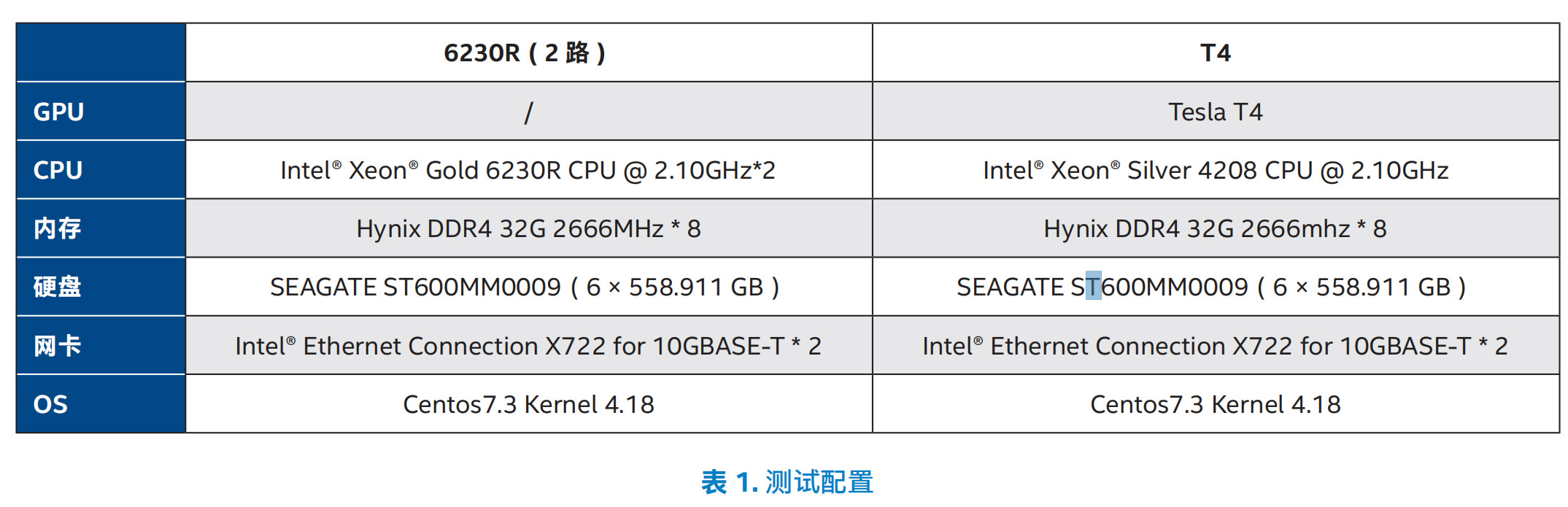

爲了驗證在 CPU、GPU 等不同平台上進行深度學習推理的性 能以及 TCO 表現,58 同城進行了相應的測試,測試采用了 基于開(kāi)源的 ResNet50 模型以及基于 Inception 和 ResNet 組 合的 ResNeXt 模型,這兩種模型皆應用在 58 同城的實際業 務中(zhōng)。參測的推理服務器分(fēn)别基于英特爾® 至強® 金牌 6230R 處理器以及 T4 GPU,其中(zhōng),前者爲雙路服務器,測試配置如 表 1 所示

6230R 處理器的平台的 ResNeXt 模型推理性能是基于 GPU 平台性能的 1.56 倍,ResNet50 模型的推理性能則是後者的 1.76 倍,能夠滿足 58 同城實際業務對于性能與耗時的需求。 同時,CPU 平台通常有着更大(dà)的靈活性與動态擴展的敏捷性, 能夠幫助 58 同城更好地爲多樣化場景提供支撐。